2024. 8. 28. 15:35ㆍLLM

개요

LLM 서비스를 운영하다보니, 고객사 측에서 GPU에 대해 물어보는 경우가 빈번합니다.

우리 상황에 맞는 GPU 추천 좀 해주실 수 있나요?

질문이 들어올 때마다, 개발자분들에게 의지했지만, 기본적인 내용이라도 알아야할 것 같아 해외 레퍼런스를 찾던 중,

잘 정리된 게시물이 있어 해당 게시물의 일부분을 가져와본다.

해당 게시물은 Tim Dettmrs가 2023년 1월 30일에 게시한 글입니다.

👉 원문: Which GPU(s) to Get for Deep Learning: My Experience and Advice for Using GPUs in Deep Learning

The Best GPUs for Deep Learning in 2023 — An In-depth Analysis

Here, I provide an in-depth analysis of GPUs for deep learning/machine learning and explain what is the best GPU for your use-case and budget.

timdettmers.com

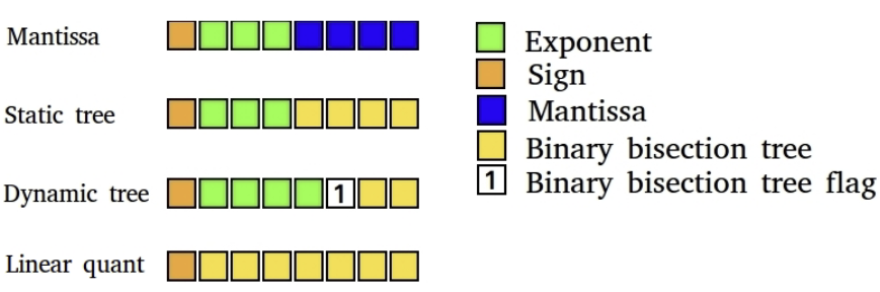

낮은 정밀도 계산

GPU 기본 성능(raw performance)

✅ 아래 표에서 모든 GPU의 기본 성능 차트 확인할 수 있음

✅ H100 GPU의 8-bit 성능과 16-bit 성능에 최적화된 구형 카드 간에는 엄청난 격차 있음

표시된 것은 GPU의 원시

예를 들어 RTX 4090은 8-bit 추론에서 H100 SMX의 약 0.33배 성능 제공

즉, 8-bit 추론에서 H100 SMX가 RTX 4090에 비해 3배 더 빠름

1 달러당 GPU 딥러닝 성능

✅ 아래는 8-bit 추론 성능별로 정렬된 모든 GPU의 달러당 성능 차트

✅ 이 차트 사용해 자신에게 적합한 GPU 찾는 방법은 다음과 같음

1️⃣ 필요한 GPU 메모리 양 결정

- 대략적으로 이미지 생성의 경우 최소 12GB, 트랜스포머 작업의 경우 최소 24GB

2️⃣ 8-bit 학습과 인퍼런스의 경우 아직 실험 단계(2023년 1월 기준으로, 6개월 이내에 표준될 것이라고 명시)

- 8-bit의 경우 작업하기 위해 추가적인 코딩 수행해야 할 수도 있음

- 그렇기 싫다면, 16-bit 성능 선택

3️⃣ 2번째 단계에서 결정한 지표 사용해 필요한 메모리 양을 가진 상대적 성능/달러 가장 높은 GPU 찾기

✅ 8-bit, 16-bit 추론에서는 RTX 4070 Ti가 가장 비용 효율적

✅ 16-bit 학습에서는 RTX 3080이 가장 비용 효율적

✅ 이러한 GPU는 가장 비용 효율적이나, 다양한 사용 사례에 충분한 메모리가 없기 때문에 반드시 권장하지는 않음

✅ 하지만, 딥러닝을 시작하기에 이상적인 선택

✅ 이러한 GPU(RTX 4070 Ti 또는 RTX 3080)는 더 작은 모델 사용하는 캐글 경쟁 등에 탁월하다고 설명하고 있음

✅ 캐글 competition에서 좋은 성적 받기 위해서는, 모델 크기보다 작업 방식이 더 중요하기에 작은 GPU 중 다수는 캐글 대회에 탁월함

✅ 교육용 및 스타트업 서버에 가장 적합한 GPU는 A6000 Ada GPU

✅ H100 SXM GPU도 매우 비용 효율적이며 높은 메모리와 매우 강력한 성능 제공

✅ 회사/학계 연구소 위한 소규모 클러스터 구축한다면 66~80%는 A6000 GPU, 20~33%는 H100 SXM GPU 사용할 것

✅ 만약, L40 GPU 저렴하게 구매할 수 있다면 A6000 대신 L40 선택할 것

차트 이해하는 방법

✅ RTX 4070 Ti를 5년동안 보유한 데스크톱 컴퓨터는 RTX 3090 GPU에 비해 달러당 8비트 추론 성능이 약 2배 높음

✅ 데스트톱 컴퓨터 비용과 각 GPU의 평균 아마존 및 이베이 가격으로 정규화된 GPU의 미국 달러당 상대적 성능

✅ 또한, 5년간 전력소모비에는 kWh당 0.175 달러의 전기 요금과 15%의 GPU 사용률 추가됨

✅ RTX 4090의 전기비용은 연간 100달러

GPU 추천 차트

* 해당 추천 차트의 경우, 2023년 1월에 작성된 내용으로 2024 최신 GPU에 맞게 업데이트 필요

✅ 아래 차트는 GPU 추천 flow chart

✅ 선택에 도움을 받을 수 있으나, 옵션이 너무 비싸서 적합하지 않을 수도 있음

✅ 그럴 경우에는, 위의 벤치마크 살펴보고 사용 사례에 맞는 충분한 GPU 메모리 갖춘 가장 비용 효율적인 GPU 선택

✅ vast.ai나 Lambda Cloud에서 필요한 GPU 메모리 추정할 수 있음

✅ 매일 높은 사용률(매일 12시간)로 수개월동안 GPU 사용하는 경우에는 일반적으로 클라우드 GPU는 좋은 옵션 아님

첨언

위의 글은 2023년 1월에 작성된 내용이기에 새로 업데이트가 필요하다고 생각됩니다.

자유롭게 댓글주시면 해당 내용 토대로 업데이트하겠습니다.

피드백은 언제나 환영입니다:)

'LLM' 카테고리의 다른 글

| LLM 정확도 최적화 위한 멘탈 모델(작성중) (0) | 2024.09.12 |

|---|---|

| LLM 서비스하는데 필요한 GPU 메모리 계산하기 (2) | 2024.08.26 |

| [인공지능] 구글 딥마인드에서 정의한 AGI 5단계(규칙 기반 에이전트 ~ 자율 에이전트) (1) | 2024.07.11 |

| [SK TECH SUMMIT 2023] LLM 적용 방법인 RAG VS PEFT, Domain 적용 승자는? (1) | 2024.05.02 |